Existen tantos tablets diferentes hoy en día que cualquiera puede aprovecharse de ello para elegir el que más se ajusta a tus necesidades. A menos, claro está, que tus gustos te lleven a preferir algo estrafalario como dos pantallas unidas por una bisagra. Si esta es tu opción, Sony Tablet P es lo que necesitas. Su diseño es simple como pocos. La construcción en forma de concha es una reminiscencia de los viejos PDAs, como los famosos Series 5 de Psion y el Nokia Communicator, pero si lo abres encontrarás dos pantallas en lugar de una y un teclado.

Estas pantallas tienen 5,5 pulgadas de diagonal y 1.024 x 480 píxeles cada una. En muchos casos trabajan en equipo para simular una pantalla única más grande, salvo que existe un hueco de 9 mm entre ambas, y eso realmente molesta. ¿Quién quiere una banda negra en medio de una página web blanca? Tampoco las pantallas aprovechan el ancho total del chasis.

Los bordes laterales son grandes, casi 24 mm; el superior e inferior son de 12 mm. Esta gran cantidad de espacio no utilizado produce un aspecto decepcionante. Si este diseño se realizó para favorecer la portatilidad, entonces algo se hizo mal. El Tablet P, con sus 372 g, es ligero comparado con otros, pero cuando está cerrado es demasiado grande –demasiado grande para la mayoría de los bolsillos–.

Tiene un diseño interesante. Las partes curvas de la zona superior e inferior son extraíbles. Una protege la ranura de la tarjeta SIM y la otra protege la batería (3.080 mAh) y el slot de la microSD. Sus características técnicas son buenas. Tiene un procesador de doble núcleo a 1 GHz, 1 GB de RAM y 4 GB de almacenamiento. Tiene dos cámaras, en el exterior una de 5 MP y una de resolución VGA en el interior . Sony ha instalado una versión 3.2 de Android, a la que ha dado unos ligeros retoques y ha completado con algunas apps de su propia creación, como las “stores” Music Unlimited y Video Unlimited. También tiene una buena app DLNA.

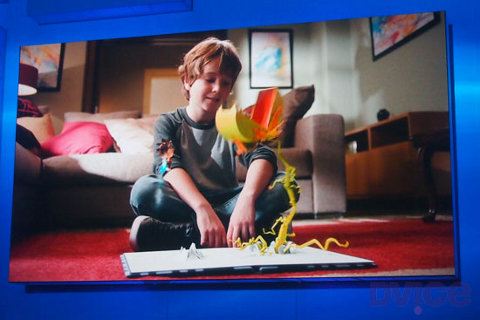

La pantalla del Sony Tablet P no es mala, al fin y al cabo. Una vez que te acostumbras empezarás a msacarle partido. Puedes, por ejemplo, escribir un mensaje en un teclado virtual situado en la pantalla inferior y ver el texto en la superior; o ejecutar juegos PlayStation para Android en la de arriba, mientras que los controles se dibujan en la de abajo. En definitiva,

no podemos decir que hayamos quedado convencidos con el sistema de doble pantalla. La proporción de la pantalla en modo completo no encaja con la mayoría de las apps: verás grandes bordes alrededor, además del hueco entre ellas. Desgraciadamente, pocas apps se aprovechan de las ventajas de este sistema. Y Sony no ha avanzado mucho más, hubiese estado muy bien que permitiera ejecutar dos aplicaciones a la vez, cada una en una zona. Admiramos la valentía del fabricante diseñando el Tablet P, pero el resultado final no funciona.

Características Técnicas.

- Sistema operativo: Android 3.2.

- Procesador: NVIDIA Tegra 2 dual-core 1 GHz.

- Memoria: 4 GB, 1 GB de RAM.

- Tienda de Apps: Google Play.

- Dimensiones: 180 x 158 x 22 mm.

- Peso: 372 g.

- Tamaño de la pantalla: 2 x 5,5 pulgadas.

- Resolución de la pantalla: 2 x 1.024 x 480.

- Ranura de expansión: microSD.

Precio

Su precio se inicia en los 499 euros.